安徽省重點新聞門戶網站

安徽省重點新聞門戶網站

安徽青年報官方網站

安徽青年報官方網站

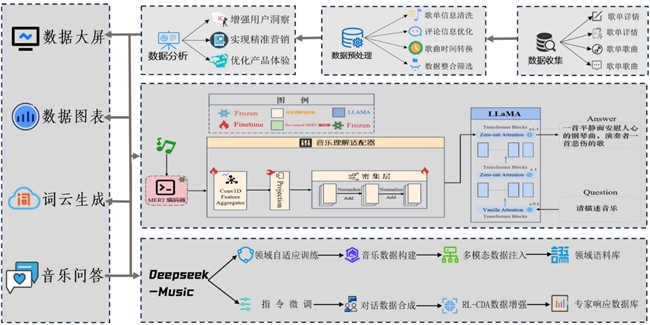

EchoSphere:云音數智全景分析系統助力音樂產業智慧升級

數字時代,音樂的感知與創作正步入AI智能新時代。由安徽農業大學趙雨陽等人開發的“EchoSphere:云音數智全景分析系統”正式發布。該系統創新性融合“MelodyIQ+DeepSeek-Music”雙引擎技術,全面推動音樂生態從流量經濟向價值經濟轉型。

EchoSphere系統以網易云音樂平臺的海量用戶行為數據為基礎,依托先進的音樂理解與專業知識圖譜技術,構建出覆蓋音樂感知、語義理解和內容生成的完整技術鏈路。MelodyIQ引擎通過神經編碼技術高效提取旋律、和聲和節奏的“音樂DNA”,精準解析音頻特征;而DeepSeek-Music引擎則基于百億級專業音樂語料與知識圖譜,深入剖析作曲技法、音樂風格與文化內涵,實現了對音樂的深層次理解。

團隊通過創新性的QLoRA微調策略和動態演化機制,突破傳統音樂AI模型難以跨越的“特征-語義”割裂,首次實現了從聲波振動到藝術內涵的端到端認知解析。項目還成功構建了1.2TB的多模態MusicMeta數據集,涵蓋214種細粒度標簽,極大增強了模型對不同文化音樂的理解力,填補了民族與稀缺流派數據的空白。

EchoSphere不僅能為用戶提供精準的“用戶-內容-場景”三維推薦服務,避免了傳統推薦系統的信息繭房問題,更能為創作者提供專業級作曲建議及技法解析。此外,系統的動態學習路徑和實時演奏糾錯模塊,顯著提升了音樂教育的沉浸感和交互性。

項目實驗證明,EchoSphere系統在音樂技法分析準確率提升至89%以上,跨模態情感對齊度達到行業領先的0.92(MuLan Score),并實現了10萬條每分鐘的實時評論處理能力和200毫秒以內的響應速度,完美滿足高并發需求。

EchoSphere系統的問世標志著音樂智能分析與創作進入全新時代,未來必將進一步推動數字音樂產業向智能化、精準化、專業化的方向發展。(趙雨陽)

責任編輯:杜宇

- 2025-07-04 歙縣街口鎮:三維發力筑牢新安江畔生態屏障

- 2025-07-04 植物醫生以科研創新驅動增長,展現國貨品牌的科技突圍之路

- 2025-07-04 植物醫生:植根東方特色護膚文化,讓世界愛上中國化妝品

- 2025-07-04 洪鋪鎮:夜間聯合執法,打擊非法垂釣捕撈

- 2025-07-04 桐城市青草鎮:聚焦安全度汛 多措并舉保豐收

贊一個

贊一個